NVIDIA A100 Tensor Core GPU 現已登陸 Google Cloud。

A100 推出後一個月便在 Google Compute Engine 中以 alpha 版的形式使用,成為 NVIDIA 有史以來最快登陸雲端的 GPU。

今天推出搭載 A100 的 Accelerator-Optimized VM (A2) 執行個體家族,使 Google 成為首家提供全新 NVIDIA GPU 的雲端服務供應商。

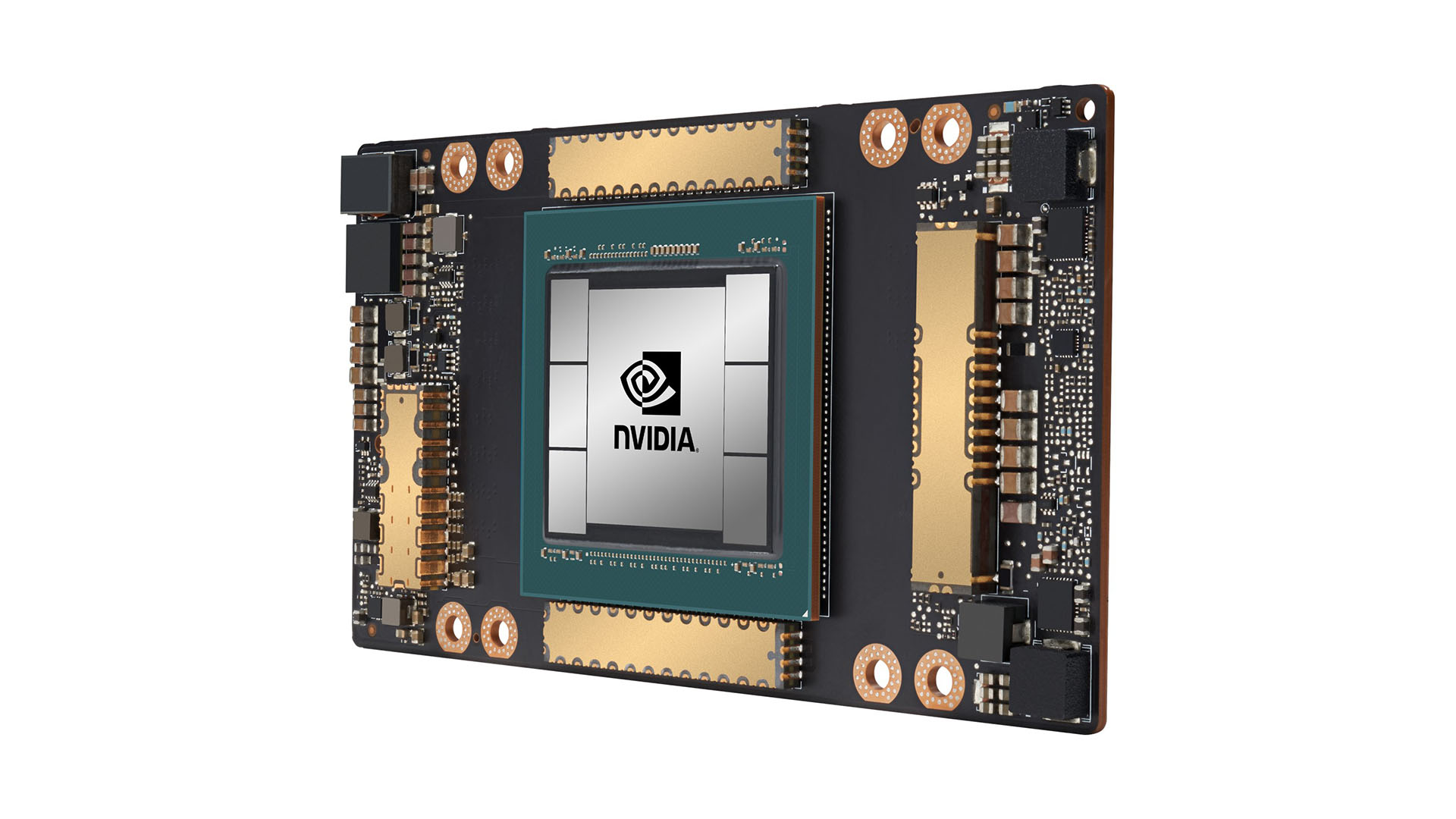

基於最新推出的 NVIDIA Ampere 架構打造的 A100,是 NVIDIA GPU 有史以來最大的世代飛躍。相較過去的 GPU,A100 將訓練和推論運算效能提高 20 倍以上,並大幅加快作業負載的速度,以推動人工智慧 (AI) 革命。

Google Cloud 產品管理總監 Manish Sainani 表示:「Google Cloud 的用戶經常希望我們提供最新的硬體和軟體服務,以幫助他們推動人工智慧和科學運算作業負載的創新。如同當時成為首家導入 NVIDIA T4 GPU 的供應商一樣,我們憑藉全新的 A2 VM 系列,很榮幸成為市場上首家採用 NVIDIA A100 GPU 的主要雲端供應商。我們很期待看到我們的用戶將如何運用這些新功能。」

在雲端資料中心中,A100 可以支援廣泛的運算密集型應用程式,包含 AI 訓練和推論、資料分析、科學運算、基因組學、邊緣影像分析與 5G 服務等。

透過 Google Compute Engine 上 A100 的突破性效能,將能讓快速發展的關鍵性產業加快探索速度。從垂直擴充 AI 訓練和科學運算,到水平擴充推論應用程式,再到實現即時對話式 AI,A100 可以加速在雲端運行的各種複雜且不可預測的作業負載規模。

即將問世的 NVIDIA CUDA 11 讓開發者可以使用 NVIDIA A100 GPU 的全新功能,包含 Tensor Cores、混合精度模式、多執行個體 GPU、先進的記憶體管理以及標準 C ++/Fortran 平行語言結構。

全新 A2 VM 執行個體可以提供不同等級的效能,能在支援 CUDA 的機器學習訓練與推論、資料分析,以及高效能運算中有效地加速作業負載。

針對大型且要求嚴苛的作業負載,Google Compute Engine 為用戶提供搭載 16 個 A100 GPU 的 a2-megagpu-16g 執行個體,並以最大容量 9.6TB / s 的總頻寬透過 NVSwitch 連接,總共提供 640GB 的 GPU 記憶體和 1.3TB 的系統記憶體。

對於作業負載較小的用戶,Google Compute Engine 也提供較小配置的 A2 VM,以滿足特定應用程式的需求。

Google Cloud 宣布 NVIDIA A100 即將擴大支援 Google Kubernetes Engine、Cloud AI Platform 和其他 Google Cloud 服務。