因應疫情關係,實體 GTC 2020 算是全面取消,但作為 NVIDIA 的 CEO 黃仁勳在台灣時間 5 月 13 日晚間還是公布數支預錄的影片公布公司的接下來的產品以及規劃,但這並不包含大家較為期待的 GeForce 系列顯示卡,畢竟過去的 GTC 並不是真正公布 GeForce 顯示卡的場合。

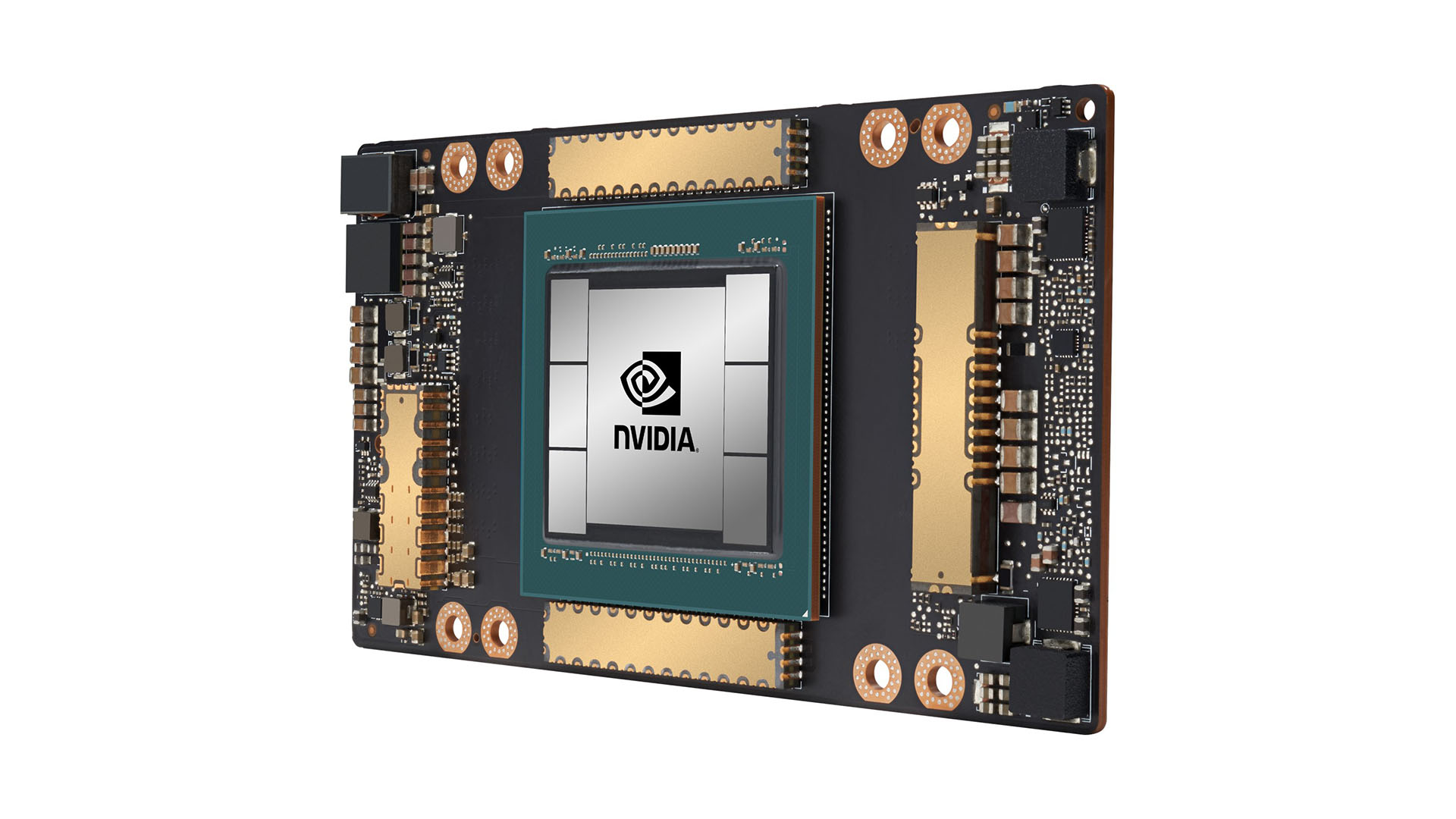

在系列產品中,較為接近 GeForce 顯示卡的應該是屬 A100 GPU,因為採用的是已經醞釀很久的 Ampere 架構 GPU;Ampere 架構接替 2017 年所公布的 Volta 架構,鎖定於高階運算市場,其中包括 Datacenter 以及 AI 運算領域。

| P100 | V100 | A100 | |

|---|---|---|---|

| Architecture | Pascal | Volta | Ampere |

| Process Node | TSMC 16nm FinFET | TSMC 12nm FFN | TSMC 7N |

| GPU | GP100 | GV100 | A100 |

| Transistor Count | 15.3B | 21.1B | 54.2B |

| TDP | 300W | 300 / 350W | 400W |

| FP32 CUDA Cores | 3584 | 5120 | 6912 |

| Boost Clock | 1480MHz | 1530MHz | ~ 1410MHz |

| Memory Clock | 1.4Gbps HBM2 | 1.75Gbps HBM2 | 2.4Gbps HBM2E |

| Memory Bus Width | 4096 bit | 4096 bit | 5120 bit |

| Memory Bandwidth | 720GB/s | 900GB/s | 1.6TB/s |

| VRAM | 16GB | 16GB / 32GB | 40GB |

| Single Precision | 10.6 TFLOPs | 15.7 TFLOPs | 19.5 TFLOPs |

| Double Precision | 5.3 TFLOPs (1/2 FP32 rate) | 7.8 TFLOPs (1/2 FP32 rate) | 9.7 TFLOPs (1/2 FP32 rate) |

| INT8 Tensor | - | - | 624 TOPs |

| FP16 Tensor | - | 125 TFLOPs | 312 TFLOPs |

| TF32 Tensor | - | - | 156 TFLOPs |

| Interconnect | NVLInk 1 4 Links(160GB/s) | NVLink 2 6 Links(300GB/s) | NVLink 3 12 Links(600GB/s) |

| Interface | SXM | SMX2 / SXM3 | SXM4 |

採用 TSMC 7nm 製程的 A100 GPU 電晶體數量達到 54.2B,根本不是 V100 和 P100 可以比擬的數字。製程的提升是為了塞入更多的電晶體,這一點不需要有太多質疑,但 Ampere 不單單只是電晶體數量的增加而已。

記憶體部分從 HBM2 更換至 HBM2E,同時容量提升至 40GB(Samsung Electronics),並在 Memory Bus Width 和 Memory Bandwidth 都有明顯提升。

Ampere 架構的 A100 雖然在 Single Precision 和 Double Precision 較 Volta 架構的 V100 只有小幅度提升,但 A100 這次加入 INT8 Tensor 以及 TF32 Tensor 用以強化深度學習(Deep Learning)的 Inference 和 Training 方面的應用。INT8 Tensor 在 Volta 架構的 Tesla T4 中出現,但 V100 則沒有特別表示,而 TF32 Tensor 則是全新運算。

另外就是 Ampere 架構的 A100 功耗直接從過去的 300W / 350W 提升至 400W,但規格面的強化,功耗僅如此增幅,算是相當不錯的表現。