NVIDIA 今天宣布NVIDIA Blackwell 平台已經到來,為運算新時代提供動力,使世界各地的組織能夠在兆級參數大型語言模型上構建和運行即時生成式人工智慧(AI),而成本和能耗比其前身最低可達25 倍。

Blackwell GPU 架構具有六項用於加速運算的變革性技術,這將有助於在資料處理、工程模擬、電子設計自動化、電腦輔助藥物設計、量子運算和生成式AI方面實現突破,這些對NVIDIA都是新興產業機會。

NVIDIA 創辦人暨執行長黃仁勳表示:「三十年來,我們一直在追求加速運算,目標是實現深度學習和AI等變革性突破。生成式AI是我們這個時代的決定性技術。 Blackwell是推動這場新工業革命的引擎。,我們將與世界上最具活力的公司合作,實現人工智慧對每個產業的承諾。」

計劃採用 Blackwell 的眾多組織包括Amazon Web Services、戴爾科技集團、Google、Meta、微軟、OpenAI、甲骨文、Tesla和xAI。

Alphabet 和 Google 執行長 Sundar Pichai 表示:「將搜尋和 Gmail 等服務擴展到數十億用戶,教會了我們如何管理運算基礎設施。隨著我們進入AI平台轉型,為了自己的產品和服務,以及我們的雲端客戶,我們繼續深入投資基礎設施。我們很幸運能夠與 NVIDIA 建立長期合作夥伴關係,並期待將 Blackwell GPU 的突破性功能帶給我們整個 Google 的雲端客戶和團隊,包括 Google DeepMind,以加速未來的發現。」

亞馬遜總裁暨執行長 Andy Jassy 表示:「我們與 NVIDIA 的深度合作可以追溯到 13 年前,當時我們在 AWS 上推出了世界上第一個 GPU 雲端實例。今天,我們在雲端的任何地方提供最廣泛的 GPU 解決方案,支援世界上技術最先進的加速工作負載。這就是為什麼新的NVIDIA Blackwell GPU 將在AWS 上運作得如此出色,也是NVIDIA 選擇AWS 共同開發Project Ceiba 的原因,該專案將NVIDIA 的下一代Grace Blackwell 超級晶片與AWS Nitro System 先進的虛擬化技術和超高速Elastic Fabric Adapter 網路結合,用於NVIDIA自己的AI研發。 透過 AWS 和 NVIDIA 工程師的共同努力,我們將繼續共同創新,使 AWS 成為任何人在雲端中運行 NVIDIA GPU 的最佳場域。」

戴爾科技集團創辦人暨執行長 Michael Dell 表示:「生成式AI對於創造更智慧、更可靠和更有效率的系統至關重要。戴爾科技集團和 NVIDIA 正在共同努力塑造科技的未來。隨著 Blackwell 的推出,我們將繼續為客戶提供下一代加速產品和服務,為他們提供推動跨產業創新所需的工具。」

Google DeepMind 共同創辦人暨執行長 Demis Hassabis 表示:「AI的變革性潛力令人難以置信,它將幫助我們解決世界上一些最重要的科學問題。Blackwell突破性的技術能力將提供所需的關鍵運算,幫助世界上最聰明的人開闢全新的科學發現。」

Meta 創辦人暨執行長 Mark Zuckerberg表示:「從我們的大型語言模型到內容推薦、廣告和安全系統,AI已經為一切提供了動力,並且它在未來只會變得更加重要。我們期待使用NVIDIA 的Blackwell 幫助訓練我們的開源 Llama 模型並建立下一代的Meta AI和消費產品。」

微軟董事長暨執行長 Satya Nadella 表示:「我們致力於為客戶提供最先進的基礎設施,提供他們的AI工作負載動力。透過將 GB200 Grace Blackwell 處理器導入我們全球的資料中心,以我們在雲端最佳化NVIDIA GPU的悠久歷史為基礎,同時我們也為世界各地的組織兌現了AI的承諾。」

OpenAI 執行長 Sam Altman 表示:「Blackwell 實現了大幅的效能躍升,並將加快我們推出領先模型的能力。我們很高興繼續與 NVIDIA 合作來增強 AI 運算。」

Oracle 董事長暨技術長Larry Ellison表示:「Oracle 與NVIDIA 的密切合作將在AI、機器學習和資料分析方面實現質和量的突破。為了讓客戶發現更多可行動的洞察,必須要有像Blackwell 這樣專門為加速運算和生成式AI而構建的更強大的引擎。」

Tesla 和 xAI 執行長 Elon Musk表示:「目前沒有什麼比 NVIDIA 硬體更好的 AI 硬體了。」

此全新架構以David Harold Blackwell命名,紀念這位專門研究賽局理論和統計學的數學家,他也是第一位入選美國國家科學院的黑人學者。此架構繼承了兩年前推出的NVIDIA Hopper 架構。

Blackwell 的六項革命性技術共同支援AI訓練和即時大型語言模型推理,模型可擴展至 10 兆個參數。其中包括:

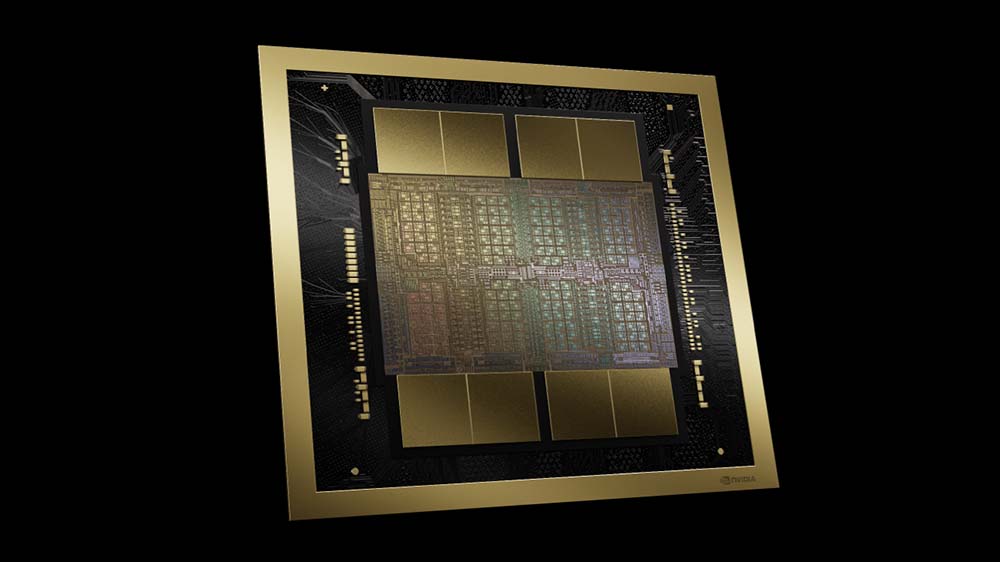

– 世界上最強大的晶片:Blackwell 架構 GPU 配備了 2080 億個電晶體,採用台積公司客製化4奈米製程製造,兩倍光罩尺寸GPU裸晶透過10 TB/s的晶片到晶片互連連接成單個、統一GPU。

– 第二代 Transformer 引擎:透過新的微張量擴展(micro-tensor scaling)支援以及NVIDIA的先進動態範圍管理演算法整合到NVIDIA TensorRT-LLM和NeMo Megatron框架中,Blackwell將利用新的4位浮點AI推論能力支援加倍地運算和模型尺寸。

– 第五代NVLink:為了加速多兆參數和混合專家(mixture-of-experts) AI模型的效能,最新版本的NVIDIA NVLink提供了每個GPU驚人的1.8TB/s的雙向吞吐量,確保在最複雜的大型語言模型中高達576個GPU之間實現無縫的高速溝通。

– RAS 引擎:Blackwell 驅動的 GPU 包含一個專用引擎,可實現可靠性、可用性和可服務性。 此外,Blackwell 架構還增加了晶片級功能,利用基於AI的預防性維護來運行診斷和預測可靠性問題。 這樣可以最大化系統正常運行時間,並增強大規模AI部署的彈性,使其連續數週甚至數月不間斷地運行,並降低運營成本。

– 安全AI:先進的機密運算功能可在不影響效能的情況下保護AI模型和客戶資料,並支援新的本機介面加密協定,這對於醫療保健和金融服務等隱私敏感產業至關重要。

– 解壓縮引擎:專用解壓縮引擎支援最新格式,加速資料庫查詢,以提供資料分析和資料科學的最高效能。未來幾年,公司每年花費數百億美元的資料處理將越來越使用 GPU 加速。

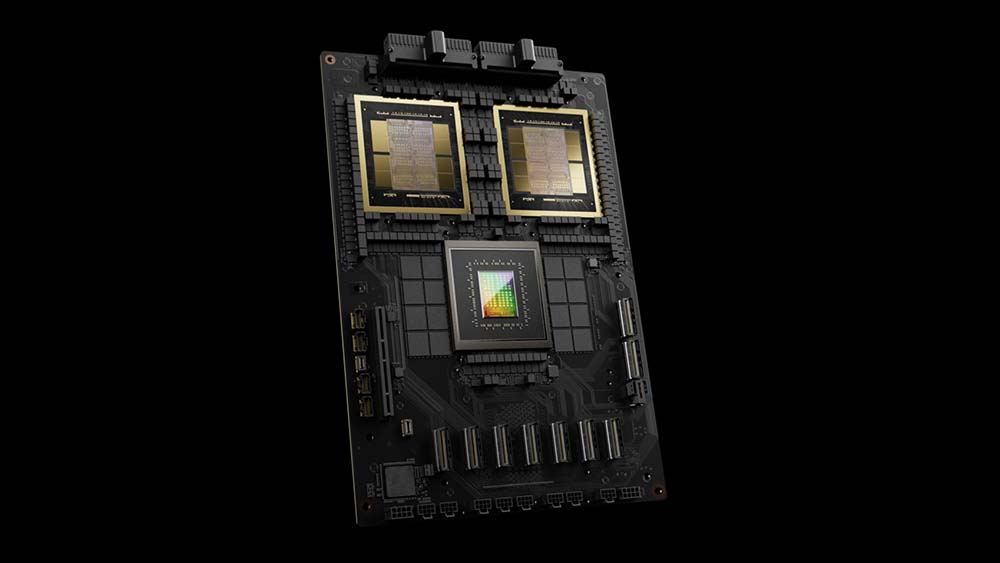

巨大的超級晶片 NVIDIA GB200 Grace Blackwell超級晶片透過 900GB/s 超低功耗NVLink晶片到晶片互連技術將兩個 NVIDIA B200 Tensor Core GPU 與NVIDIA Grace CPU連接起來。

為了獲得最高的 AI 性能,GB200 驅動的系統可以與今天宣布的 NVIDIA Quantum-X800 InfiniBand 和 Spectrum-X800 乙太網路平台連接,這些平台可提供速度高達 800Gb/s 的先進網路。

GB200 是 NVIDIA GB200 NVL72的關鍵元件,NVIDIA GB200 NVL72 是一種多節點、液冷、機架規模系統,適用於運算最密集的工作負載。 它結合了 36 個 Grace Blackwell 超級晶片,其中包括透過第五代 NVLink 互連的 72 個 Blackwell GPU 和 36 個 Grace CPU。 此外,GB200 NVL72 還包括 NVIDIA BlueField-3 資料處理單元,可在超大規模 AI 雲端中實現雲端網路加速、可組合儲存、零信任安全性和 GPU 運算彈性。 與NVIDIA H100 Tensor Core GPU相比,GB200 NVL72可提供高達30倍的大型語言模型推論工作負載效能,並將成本和能源消耗降低多達25倍。

該平台充當單一 GPU,具有 1.4 exaflops 的 AI 效能和 30TB 的快速記憶體,是最新 DGX SuperPOD 的構建塊。

NVIDIA 提供 HGX B200,此伺服器主機板能透過NVLink連接八個 B200 GPU,以支援基於 x86 的生成式 AI 平台。HGX B200 透過 NVIDIA Quantum-2 InfiniBand 和 Spectrum-X 乙太網路平台支援高達 400Gb/s 的網路速度。

合作夥伴將從今年稍晚開始提供基於 Blackwell 的產品。

AWS、Google Cloud、Microsoft Azure 和Oracle Cloud Infrastructure將成為首批提供Blackwell 驅動執行個體的雲端服務供應商。NVIDIA雲端夥伴計劃的公司包括Applied Digital、CoreWeave、Crusoe、IBM Cloud和Lambda也同樣將提供相應的產品。 主權AI 雲端也將提供基於Blackwell 的雲端服務和基礎設施,包括Indosat Ooredoo Hutchinson、Nebius、Nexgen Cloud、Oracle EU Sovereign Cloud、Oracle 美國、英國和澳洲政府雲端、Scaleway、Singtel、Northern Data Group 的Taiga Cloud、 Yotta資料服務的 Shakti Cloud 和楊忠禮電力國際。

GB200 也將在 NVIDIA DGX Cloud上提供,這是一個與領先的雲端服務供應商共同設計的 AI 平台,讓企業開發人員能夠專門存取建置和部署先進生成式AI 模型所需的基礎設施和軟體。 AWS、Google Cloud和 Oracle Cloud Infrastructure計畫在今年稍後託管基於 NVIDIA Grace Blackwell 的新執行個體。

思科、戴爾科技集團、慧與科技、聯想和美超微預計將提供基於Blackwell 產品的各種伺服器,還有Aivres、永擎電子、華碩、Eviden、鴻海、技嘉科技、英業達、和碩聯合科技、雲達科技、緯創資通、緯穎科技和雲達國際科技。

此外,包括Ansys、Cadence和Synopsys等全球領先的工程模擬公司與持續增加的軟體製造商,將使用基於Blackwell的處理器來加速用於設計和模擬電氣、機械和製造系統及零件的軟體。他們的客戶可以利用生成式AI和加速計算,更快地、以更低的成本和更高的能源效率將產品推向市場。

NVIDIA 軟體支援 用於生產級 AI 的端對端作業系統NVIDIA AI Enterprise支援Blackwell 產品組合。 NVIDIA AI Enterprise 包括今天發布的 NVIDIA NIM™ 推論微服務,以及企業可以部署在 NVIDIA 加速雲端、資料中心和工作站上的 AI 框架、函式庫和工具。